Jeszcze przed konferencją WWDC 2023, która rozpocznie się już za niecałe trzy tygodnie, Apple ogłosiło nowe funkcje dostępności, które jeszcze w tym roku trafią do iOS 17. Wśród nich jest tryb wspomaganego dostępu, funkcja syntezy własnego głosu oraz zamieniana mowy na tekst w czasie rzeczywistym.

iOS 17 – nowe funkcje dostępności

Przedstawione przez Apple nowe rozwiązania zostały stworzone z myślą o osobach z ograniczeniami wzroku, słuchu lub zdolności kognitywnych bądź motorycznych, a także dla tych, które nie mówią lub są zagrożone utratą tej zdolności.

- Osoby o ograniczonych zdolnościach kognitywnych będą mogły korzystać z trybu wspomaganego dostępu, który ułatwi im użytkowanie iPhone’a i iPada, a przy tym pozwoli na większą samodzielność.

- Osoby nieme będą mogły zamieniać mowę na tekst w czasie rzeczywistym i używać tej funkcji w trakcie połączeń i rozmów.

- Osoby zagrożone afazją będą mogły skorzystać z syntezy własnego głosu, by porozumiewać się z rodziną i znajomymi.

- Dla osób niewidomych i słabowidzących w trybie wykrywania w narzędziu Lupa pojawi się z kolei opcja wskazywania i odczytywania. Dzięki niej wskazany przez użytkownika napis zostanie odczytany na głos przez urządzenie, co ułatwi interakcje z różnymi przedmiotami, na przykład ze sprzętem gospodarstwa domowego.

Tryb wspomaganego dostępu

Tryb wspomaganego dostępu to nowy widok, który upraszcza aplikacje i interakcje do ich najważniejszych elementów tak, by zredukować obciążenia poznawcze.

Nowy tryb pozwala spersonalizować interfejs aplikacji Telefon i FaceTime, które połączono w jedną aplikację do połączeń, a także aplikacji Wiadomości, Aparat, Zdjęcia i Muzyka.

Rozwiązanie umożliwia korzystanie ze specjalnego interfejsu z kontrastowymi przyciskami i dużymi napisami, a do tego obejmuje narzędzia, które pozwalają zaufanym opiekunom dostosować widok do indywidualnych potrzeb wspieranej osoby.

Przykładowo, osoba, która preferuje komunikację wizualną, może korzystać z aplikacji Wiadomości z klawiaturą zawierającą tylko emoji i opcją komunikowania się z bliskimi poprzez nagrania wideo.

Użytkownicy i ich opiekunowie mają do wyboru dwa widoki aplikacji i ekranu początkowego. Pierwszy jest bardziej wizualny i oparty na siatce, a drugi – przeznaczony dla osób preferujących tekst – ma układ rzędowy.

Konwersja mowy na tekst w czasie rzeczywistym

Za pomocą konwersji mowy na tekst w czasie rzeczywistym na iPhonie, iPadzie i Macu można zapisać słowa, które chce się wypowiedzieć, tak by zostały odczytane na głos w czasie połączenia telefonicznego lub w aplikacji FaceTime, a także w trakcie rozmowy twarzą w twarz.

Użytkownicy mogą też zapisywać najczęściej używane przez siebie zwroty, by szybko reagować podczas ożywionych dyskusji w domu, w pracy lub wśród znajomych.

Na świecie żyją miliony osób, które nie mówią od urodzenia lub utraciły tę zdolność, i właśnie z myślą o nich opracowano funkcję konwersji mowy na tekst w czasie rzeczywistym.

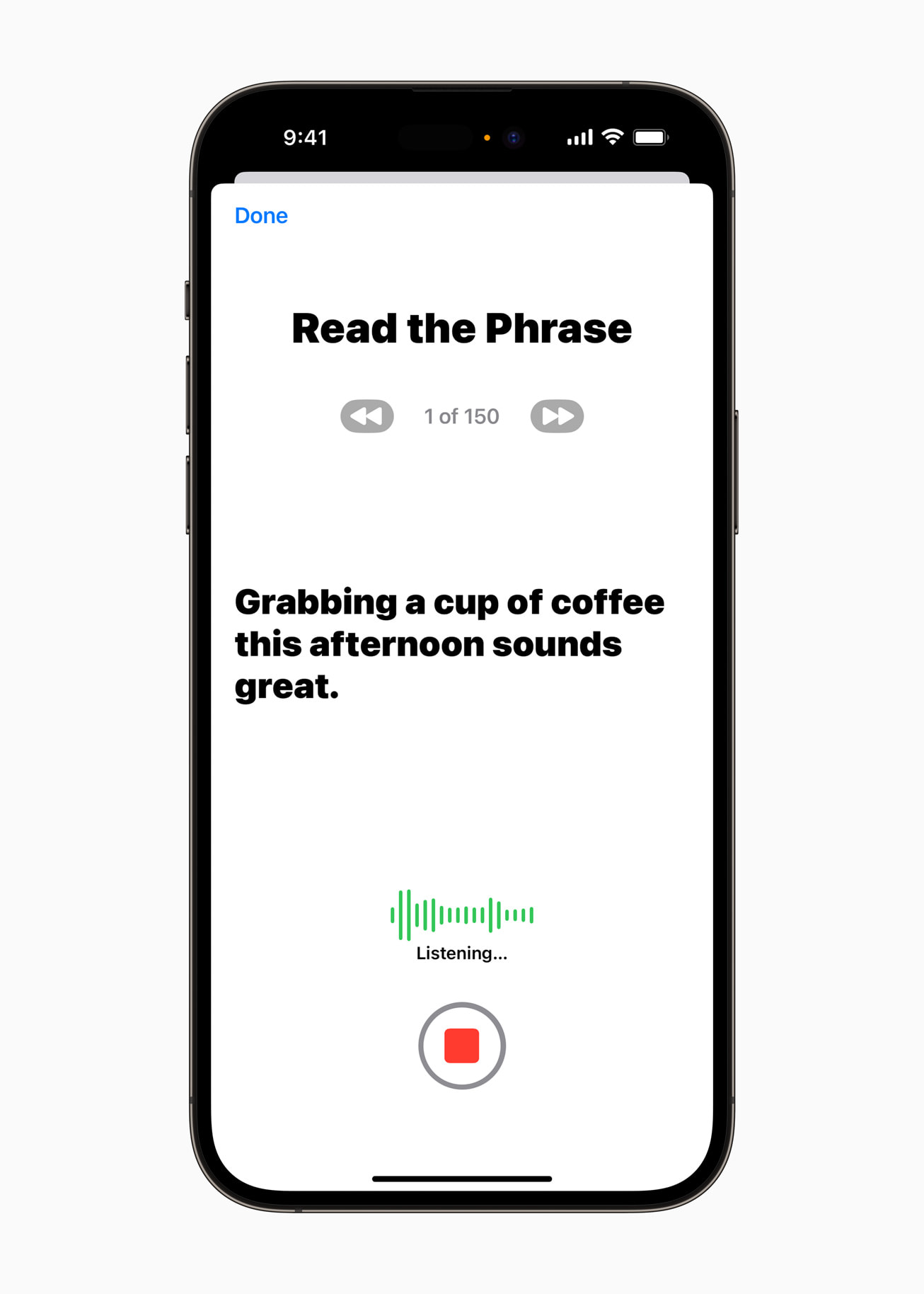

Synteza własnego głosu

Użytkownicy zagrożeni utratą mowy – na przykład osoby, u których niedawno zdiagnozowano stwardnienie zanikowe boczne (SLA) lub inne schorzenie prowadzące do stopniowego zaniku zdolności mówienia – mogą łatwo i bezpiecznie wygenerować głos, który będzie brzmiał tak jak oni.

W celu uzyskania syntezy własnego głosu należy zarejestrować na iPhonie lub iPadzie 15‑minutowe nagranie dźwiękowe, podczas którego odczytuje się na głos losowo wyświetlane teksty. To ułatwienie wykorzystuje wbudowane w urządzenie algorytmy uczenia maszynowego, dlatego informacje użytkownika i jego prywatność pozostają bezpieczne. Ponadto rozwiązanie współdziała z funkcją konwersji tekstu na mowę w czasie rzeczywistym, dzięki czemu użytkownicy mogą komunikować się z bliskimi własnym głosem.

“Możliwość powiedzenia bliskim własnym głosem, że się ich kocha, jest bezcenna, a fakt, że za pomocą iPhone’a w 15 minut można nagrać syntezę swojego głosu, jest czymś niesamowitym” – tłumaczy Philip Green, członek zarządu i rzecznik społeczności osób chorych na SLA w organizacji non profit Team Gleason, którego zdolność mówienia znacząco zmalała od 2018 r., gdy zdiagnozowano u niego SLA.

Opcja wskazywania i odczytywania w trybie wykrywania w narzędziu Lupa

Opcja wskazywania i odczytywania w narzędziu Lupa ułatwia użytkownikom z ograniczeniami wzrokowymi korzystanie z przedmiotów, na których znajdują się różne napisy. Przykładowo, gdy korzysta się ze sprzętów gospodarstwa domowego takich jak kuchenka mikrofalowa, funkcja wskazywania i odczytywania wykorzystuje informacje z aparatu, skaner LiDAR i wbudowane algorytmy uczenia maszynowego, aby odczytać napis na każdym przycisku, po którym użytkownik przesuwa palcem2. Funkcja wskazywania i odczytywania jest wbudowana w aplikację Lupa na iPhonie i iPadzie, a także doskonale zintegrowana z czytnikiem VoiceOver. Może też współdziałać z innymi narzędziami w aplikacji Lupa, takimi jak Wykrywanie osób, Wykrywanie drzwi lub Opisy obrazków, by pomagać użytkownikom w interakcjach z fizycznymi obiektami w ich otoczeniu.

Dodatkowe nowe funkcje dostępności

- Osoby głuche i słabosłyszące mogą łączyć aparaty słuchowe Made for iPhone w parę z komputerem Mac, aby skonfigurować je w optymalny dla siebie sposób3.

- Funkcję sterowania głosowego rozszerzono o sugestie fonetyczne modyfikujące tekst, by w wypadku podobnie brzmiących słów, takich jak angielskie „do”, „due” i „dew”, osoba korzystająca z konwersji mowy na tekst mogła wybrać właściwy wyraz4. Ponadto przygotowano przewodnik po sterowaniu głosowym, w którym można znaleźć wskazówki dotyczące stosowania poleceń dźwiękowych jako alternatywy dla pisania i dotykowej obsługi iPhone’a, iPada i Maca.

- Osoby z ograniczeniami fizycznymi i motorycznymi mogą korzystać z funkcji Sterowanie przełącznikami, która pozwala zmienić każdy przełącznik w kontroler do gier, aby grać w ulubione tytuły na iPhonie lub iPadzie.

- Osoby słabowidzące mogą teraz łatwiej dostosować rozmiar tekstuw aplikacjach na Macu, takich jak Finder, Wiadomości, Mail, Kalendarz i Notatki.

- Automatyczne zatrzymywanie obrazów z ruchomymi elementami, na przykład GIF‑ów, w Wiadomościach i Safari to z kolei rozwiązanie przygotowane dla osób wrażliwych na dynamiczne animacje.

- Gdy korzysta się z czytnika VoiceOver, Siri brzmi naturalnie i ekspresyjnie nawet przy dużej szybkości wypowiedzi. Prędkość tę można ponadto regulować w zakresie od 0,8x do 2x.