W iOS 16 Apple ulepszyło dźwięk przestrzenny z dynamicznym śledzeniem ruchu głowy. Ma być teraz jeszcze lepszy, dzięki personalizacji – dopasowaniu do konkretnego użytkownika. Co ciekawe, konfigurację spersonalizowanego Spatial Audio wykonuje się przy użyciu kamery TrueDepth w iPhonie.

Spatial Audio – jak działa dźwięk przestrzenny ze śledzeniem ruchów głowy

Spatial Audio, czyli dźwięk przestrzenny od Apple z funkcją śledzenia ruchów głowy, zasadniczo “bierze” dźwięk w formacie 5.1, 7.1 lub Dolby Atmos, a następnie, wykorzystując specjalne algorytmy i filtry kierunkowe audio, dostosowuje częstotliwości, które słyszy każde ucho.

Dzięki temu dźwięki odtwarzane przez dwie słuchawki można umieścić praktycznie w dowolnym miejscu w przestrzeni 3D. Użytkownikowi wydaje się w ten sposób, że poszczególne dźwięki dochodzą z przodu, z boków, z tyłu, a nawet z góry, co finalnie sprawia wrażenia dźwiękowe przebywania w przestrzeni 3D.

Dodatkowo, dzięki funkcji śledzenia ruchu głowy, w momencie, kiedy użytkownik kręci głową w prawo lub w lewo, dźwięki i ich częstotliwości są przeliczane, a następnie odtwarzane tak, że użytkownikowi wydaje się, że to on zmienił swoje położenie względem dźwięku, czyli tak, jak wyglądałoby to w rzeczywistości, gdyby dźwięki faktycznie dochodziły z otoczenia, a nie ze słuchawek.

Nowość iOS 16 – spersonalizowany dźwięk przestrzenny

Aby poprawnie umiejscawiać różne dźwięki w określonych miejscach w przestrzeni 3D Apple używa systemu HRTF (Head-Related Transfer Functions), który w matematyczny sposób oblicza i opisuje takie parametry, jak wewnętrzny kształt ucha, odległość między jednym a drugim uchem, wielkość głowy itd.

W związku z tym, że u każdego użytkownika te parametry wyglądają nieco inaczej, na podstawie wykonanych wcześniej tysięcy pomiarów Apple uśredniało te wartości tak, by niezależnie kto założy AirPodsy wspierające Spatial Audio, efekt dźwięku przestrzennego był poprawny. Niestety, takie uśrednianie jednocześnie sprawiało, że nie był też doskonały.

Teraz w iOS 16, dzięki możliwości spersonalizowania dźwięku przestrzennego przy użyciu kamery True Depth (która jest w stanie dokładnie pomierzyć odległości w trzech wymiarach) użytkownik może wykonać skan swojego lewego i prawego ucha oraz głowy, po to, by system HRTF zamiast z uśrednionych wartości Apple wykorzystał dokładny, “spersonalizowany” model obliczeń na podstawie wspomnianych skanów.

Dzięki temu dźwięk przestrzenny jest jeszcze lepszy, a umiejscowienie poszczególnych dźwięków w przestrzeni 3D jeszcze dokładniejsze.

Spersonalizowany dźwięk przestrzenny – jak to działa?

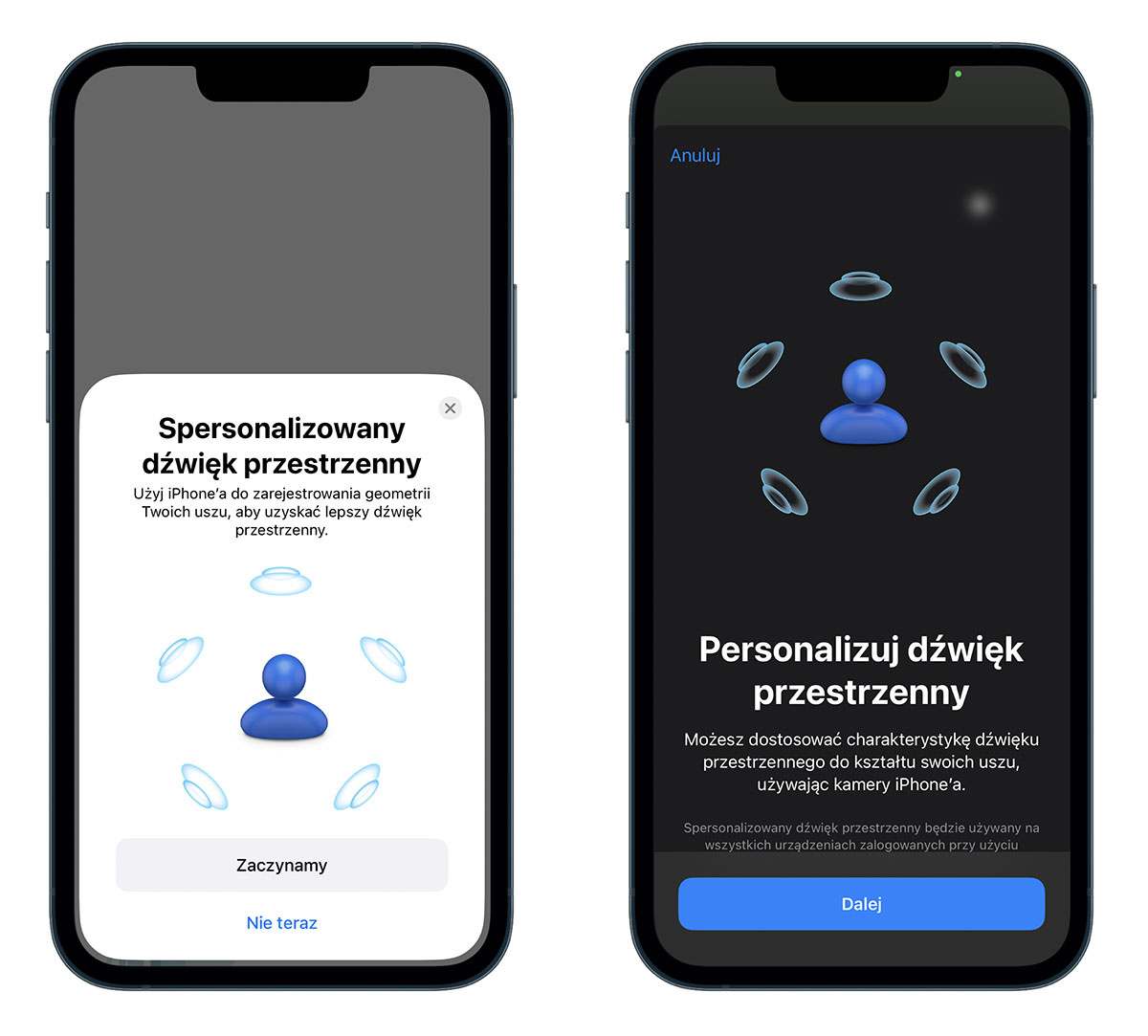

iOS 16 sam wyświetli komunikat o możliwości spersonalizowania dźwięku przestrzennego, gdy po raz pierwszy iPhone połączy się ze wspierającym Spatial Audio modelem AirPods lub Beats, czyli:

- AirPods 3. gen.

- AirPods Pro 1. i 2. gen.

- AirPods Max

- Beats Fit Pro

Jeśli taki komunikat nie pojawi się automatycznie, personalizację Spatial Audio możemy uruchomić ręcznie w: Ustawienia -> [Twoje urządzenie obsługujące dźwięk przestrzenny] > Spersonalizowany dźwięk przestrzenny > Skonfiguruj spersonalizowany dźwięk przestrzenny.

System najpierw poprosi o możliwość zeskanowania naszej twarzy, a potem prawego i lewego ucha.

-

Aby zarejestrować widok z przodu, trzymaj iPhone’a bezpośrednio przed sobą w odległości około 30 cm. Ustaw twarz w kadrze aparatu, a następnie powoli poruszaj głową dookoła, aby pokazać wszystkie kąty twarzy. Stuknij opcję Dalej.

-

Aby zarejestrować widok swojego prawego ucha, trzymaj iPhone’a w prawej ręce. Przesuń prawą rękę o 45 stopni w prawo, a następnie powoli obróć głowę w lewo. Aby zarejestrować widok lewego ucha, przełóż iPhone’a do lewej ręki. Przesuń lewą rękę o 45 stopni w lewo, a następnie powoli obróć głowę w prawo. Wskazówki dźwiękowe i wizualne pomogą Ci dokończyć konfigurację.

To wszystko. Po tej operacji dźwięk przestrzenny jest spersonalizowany.

Apple zapewnia, że nasze dane wykorzystane do tego procesu są w pełni chronione:

Dane z aparatu wykorzystywane do opracowania profilu są w całości przetwarzane na urządzeniu, a obrazy nie są przechowywane. Twój osobisty profil dźwięku przestrzennego zostanie zsynchronizowany na Twoich urządzeniach Apple przy użyciu szyfrowania kompleksowego, jeśli korzystasz z usługi iCloud. Apple nie ma do niego dostępu.

Zamów iPhone’a 14 Pro w przedsprzedaży z dostawą już 16.09!

Po zalogowaniu się przy użyciu swojego konta Apple ID możesz korzystać ze spersonalizowanego dźwięku przestrzennego na tych urządzeniach:

- AirPods Pro (1. lub 2. generacji), AirPods Max, AirPods (3. generacji) lub Beats Fit Pro

- Treści audiowizualne z obsługiwanej aplikacji

- iPhone lub iPod touch z systemem iOS 16 lub nowszym; iPad z systemem iPadOS 16.1 lub nowszym; Apple Watch z systemem watchOS 9 lub nowszym; Apple TV z systemem tvOS 16 lub nowszym lub Mac z układem scalonym Apple i systemem macOS Ventura